1) Deep Learning 기초 이론

1-1) Perceptron

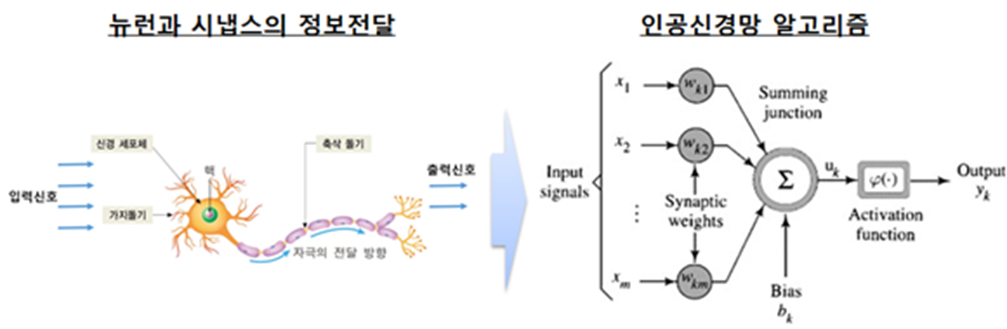

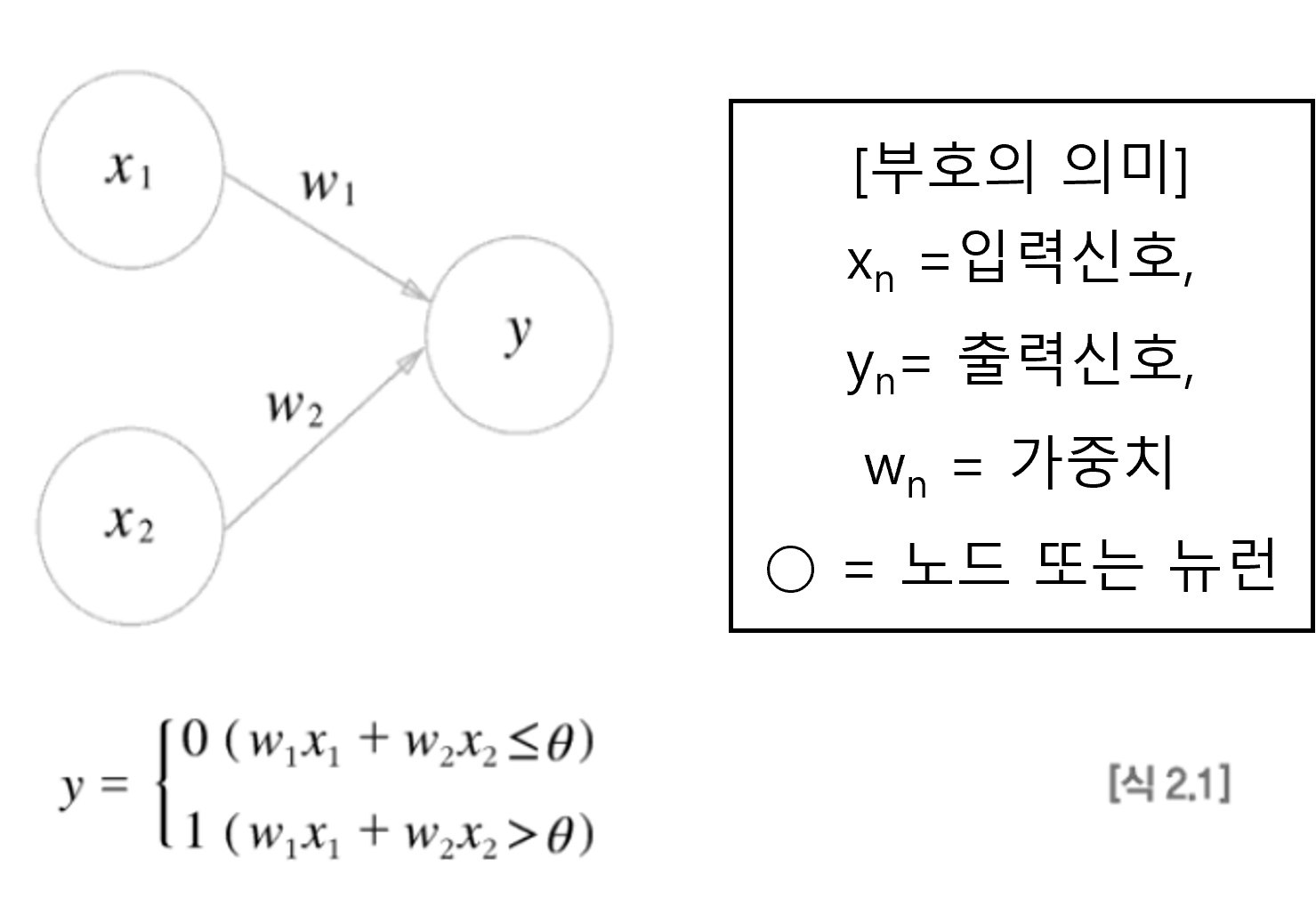

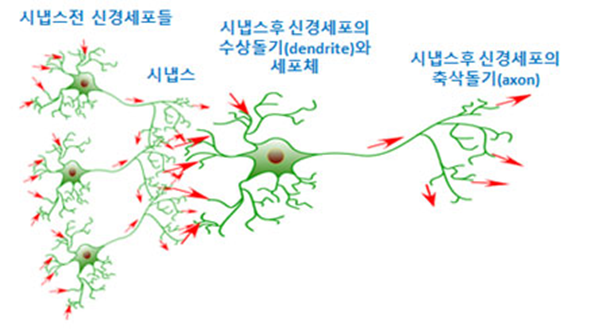

- 퍼셉트론(Perceptron)은 다수의 신호를 입력 받아 하나의 신호를 출력하는 구조이다.

- 각 입력신호는 뉴런에 보내질 때는 각각의 고유한 가중치가 곱해진다.

- 이전 뉴런에서 보내온 신호의 총합(Sum)이 정해진 한계(임계값 : theta)를 넘어설 때, ‘1’을 출력한다.

- 이를, ‘뉴런을 활성화한다’라고 표현한다.

1-2) Activation Function

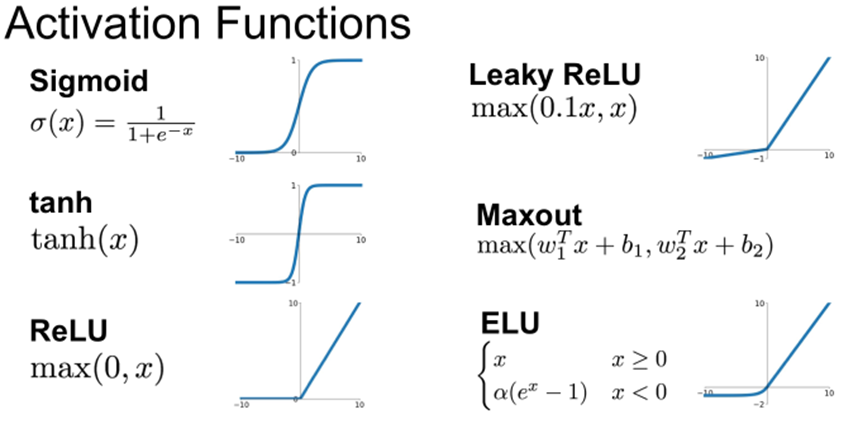

- 활성화 함수는 이전 층(layer)의 결과값을 변환하여 다른 층의 뉴런으로 신호를 전달하는 역할을 한다.

- 활성화 함수가 필요한 이유는 모델의 복잡도를 올리기 위함으로, 기존의 Machine Learning에서 가졌던 비선형 문제를 해결하는데 중요한 역할을 한다.

- 각 학습 모델(Training Model)에 맞추어 적절한 특성의 활성화 함수를 사용 필요하다

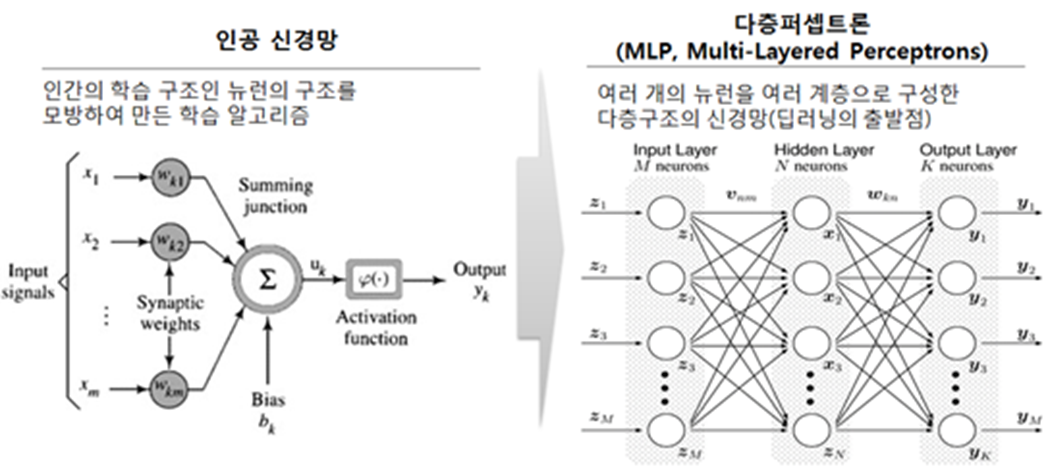

1-3) MLP(Multi-Layerd Perceptron)

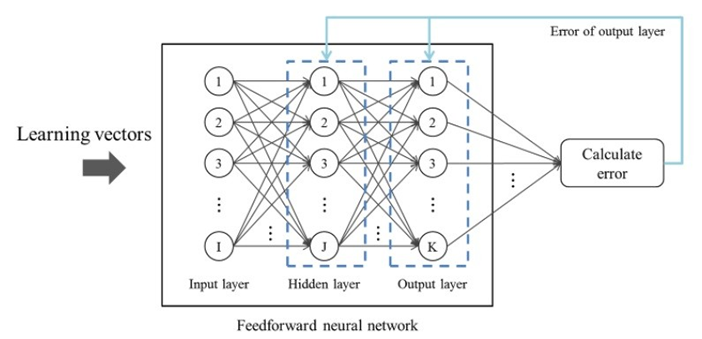

- Perceptron의 Layer가 여러 층에 걸쳐진 MLP(Multi Layer Perceptron)구조로 인공신경망을 모사할 수 있다.

- 이때, 각 Layer는 1개의 입력층(Input Layer)과 출력층(Output Layer) 사이에의 1개 이상의 은닉층(Hidden Layer)을 갖는다.

1-4) Back Propagation

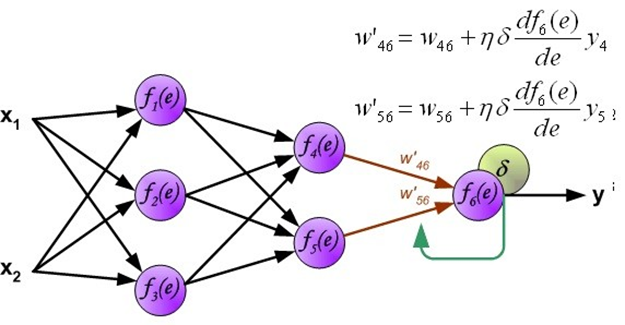

- Deep Learning의 학습(Training)은 순차적으로 연산을 한 결과인 예측 값(Prediction)과 실제 값(Lable)을 비교하여 두 값의 차이인 손실함수(Loss Funtion)을 구한다.

- 이후, 손실함수를 줄일 수 있도록 Parameter(=Weight 값 등)를 조정하며, 원하는 결과가 나오도록 학습(Training)을 시킨다.

- 이때, 이전 뉴런의 신호가 미치는 영향을 분석하도록 미분의 개념을 활용되어지며, 경사하강법(Gradient descent)을 활용하여, 손실함수를 줄여가게 된다.

2) Reference

[1] “인공지능의 머신러닝 기술 중 딥러닝 기술.” 4차산업혁명 지식서비스. 2018년 02월 26일 수정, 2023년 03월 22일 접속, https://4ir.kisti.re.kr/ick/cmmn/viewPost/20180226000067.

[2] Koki Saitoh. Deep Learning from the Basics. O’RELLY, 2021

[3] “딥러닝 활성화 함수 종류 및 특징(Activation Funtion),” Tistory Blog : 물리학과 직장인, 2020년 05년 04일 수정, 2023년 03월 22일 접속, https://muzukphysics.tistory.com/165?category=1111219.

[4] “다시 정리해본 다층퍼셉트론(MLP) : 역전파,” Naver Blog : DOTORI Shed(곳간), 2017년 6월 22일 수정, 2023년 03월 22일 접속, https://m.blog.naver.com/msnayana/221022659131. [5] 김병희. 딥러닝: 인공지능을 이끄는 첨단 기술. BI Technical Report : Biointelligence Lab, Seoul National University, 2017.